Bytedance, la empresa matriz de Tiktok, introdujo un nuevo modelo de inteligencia artificial llamado Omnihuman-1. Este modelo está diseñado para producir videos realistas utilizando fotos y clips de audio. El crecimiento sigue la decisión de OpenAI de extender el acceso a la herramienta de creación de video, Sora, ChatGPT Plus y los usuarios de Pro en diciembre de 2024. Texto o imágenes. Sin embargo, ni los modelos Operai ni los modelos de Google, que convierten las fotos en videos, están disponibles para el público.

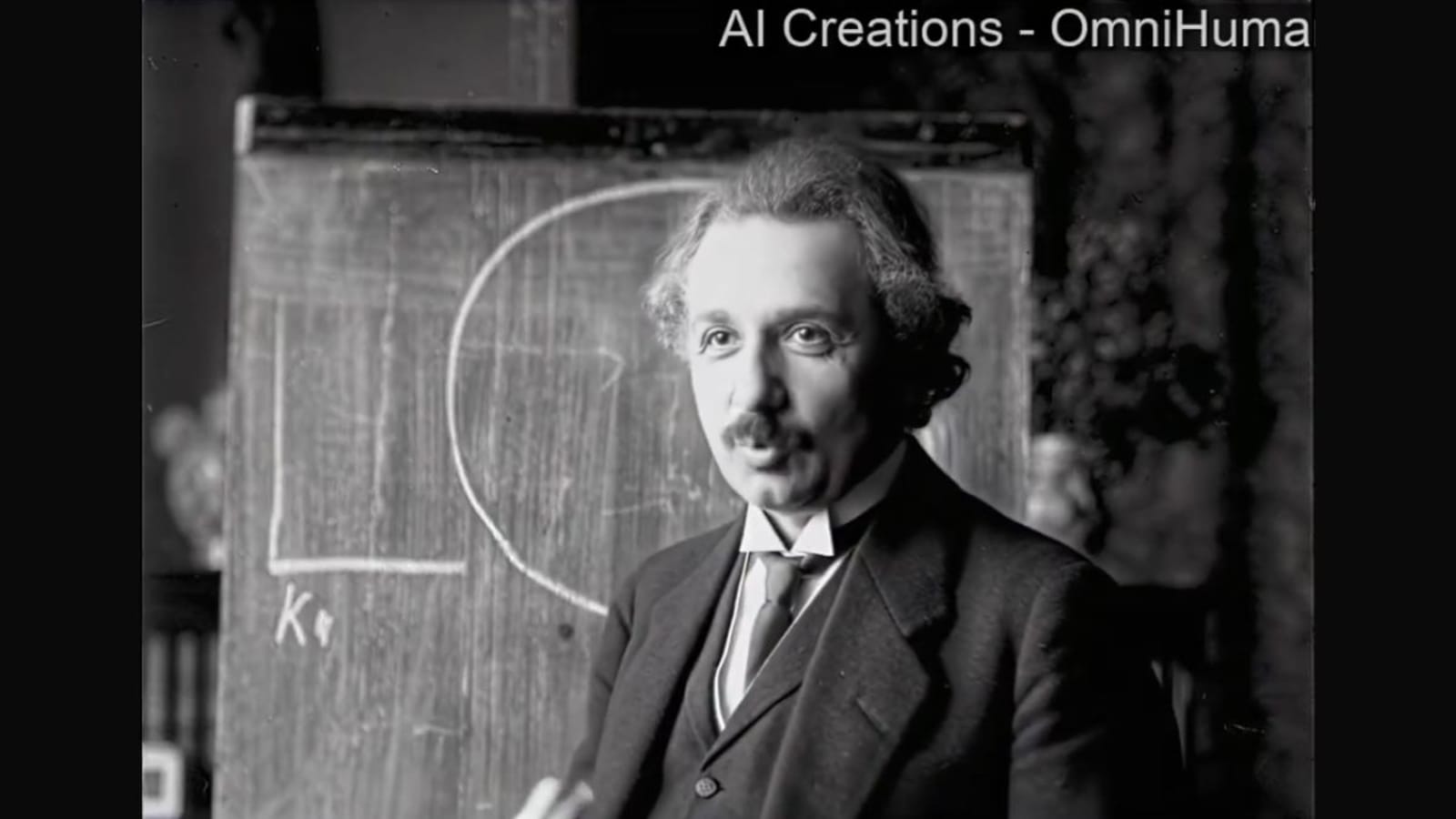

Un documento técnico (revisión del South China Morning Post) enfatiza que Omnihuman-1 se especializa en crear videos de personas que hablan, cantan y se mudan. El equipo de investigación detrás del modelo afirma que su rendimiento excede las herramientas de IA existentes que crean videos humanos basados en el sonido. Aunque Bytedance no ha lanzado el modelo para uso público, se han lanzado muestras de video en línea. Uno de ellos presenta un clip de 23 segundos de Albert Einstein que parece dar un discurso compartido en YouTube.

Lea también: Amazon comenzará a Alexa a AI el 26 de febrero, esto es lo que sabemos hasta ahora

Insights by Bytedance Investigadores

Investigadores, como Lin Gaojie, Jiang Jianwen, Yang Jiaqi, Zheng Zerong y Liang Chao, han detallado su enfoque para un documento técnico reciente. Introducieron un método de entrenamiento que incorpora múltiples conjuntos de datos, combinando texto, sonido y movimiento para mejorar los modelos de video. Esta estrategia enfrenta los desafíos de la escalabilidad que enfrentan los investigadores en la promoción de herramientas de IA similares.

Lea también: Google dice que la computación cuántica comercial despegará en solo 5 años: ¿qué significa?

La investigación enfatiza que este método mejora la producción de video sin referirse directamente a modelos competitivos. Al mezclar diferentes tipos de datos, la IA puede crear videos con diversas proporciones de dimensiones y proporciones corporales, que van desde imágenes cercanas hasta vistas completas. El modelo produce expresiones faciales detalladas sincronizadas con sonido, junto con movimientos naturales de cabeza y gestos. Estas características podrían conducir a aplicaciones más amplias en diversas industrias.

Lea también: Chatgpt Maker OpenAi ahora tiene un nuevo logotipo para que coincida con su reconstrucción. Esto parece

Entre los videos lanzados por Samples, uno tiene un hombre que proporciona una charla de Ted con gestos y movimientos del sonido sincronizado con sonido. Los observadores notaron que el video se parece mucho a la grabación de la vida real.